ceph FS 即 ceph filesystem,可以实现文件系统共享功能,客户端通过 ceph 协议挂载并使用ceph 集群作为数据存储服务器。Ceph FS 需要运行 Meta Data Services(MDS)服务,其守护进程为 ceph-mds,ceph-mds 进程管理与 cephFS 上存储的文件相关的元数据,并协调对 ceph 存储集群的访问。

![图片[1]-Ceph-FS 文件存储-李佳程的个人主页](http://www.lijiach.com/wp-content/uploads/2023/01/image-149.png)

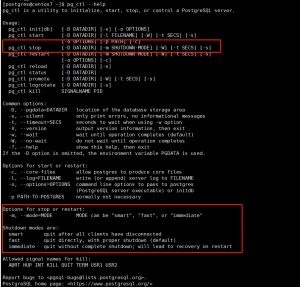

1、部署 MDS 服务

[root@mgr01 ~]# yum install -y ceph-mds

[ceph@deploy ceph-cluster]$ ceph-deploy mds create mgr01

![图片[2]-Ceph-FS 文件存储-李佳程的个人主页](http://www.lijiach.com/wp-content/uploads/2023/01/image-150.png)

2、验证 MDS 服务

MDS 服务目前还无法正常使用,需要为 MDS 创建存储池用于保存 MDS 的数据。

[ceph@deploy ceph-cluster]$ ceph mds stat

, 1 up:standby

# 当前为备用状态,需要分配 pool 才可以使用。3、创建 CephFS metadata 和 data 存储池

使用 CephFS 之前需要事先于集群中创建一个文件系统,并为其分别指定元数据和数据相关的存储池,如下命令将创建名为 mycephfs 的文件系统,它使用 cephfs-metadata 作为元数据存储池,使用 cephfs-data 为数据存储池。

[ceph@deploy ceph-cluster]$ ceph osd pool create cephfs-metadata 32 32

pool 'cephfs-metadata' created

[ceph@deploy ceph-cluster]$ ceph osd pool create cephfs-data 64 64

pool 'cephfs-data' created

[ceph@deploy ceph-cluster]$ ceph -s

cluster:

id: 845224fe-1461-48a4-884b-99b7b6327ae9

health: HEALTH_OK

services:

mon: 3 daemons, quorum mon01,mon02,mon03

mgr: mgr01(active), standbys: mgr02

osd: 15 osds: 15 up, 15 in

rgw: 1 daemon active

data:

pools: 8 pools, 224 pgs

objects: 278 objects, 300 MiB

usage: 16 GiB used, 1.4 TiB / 1.5 TiB avail

pgs: 224 active+clean

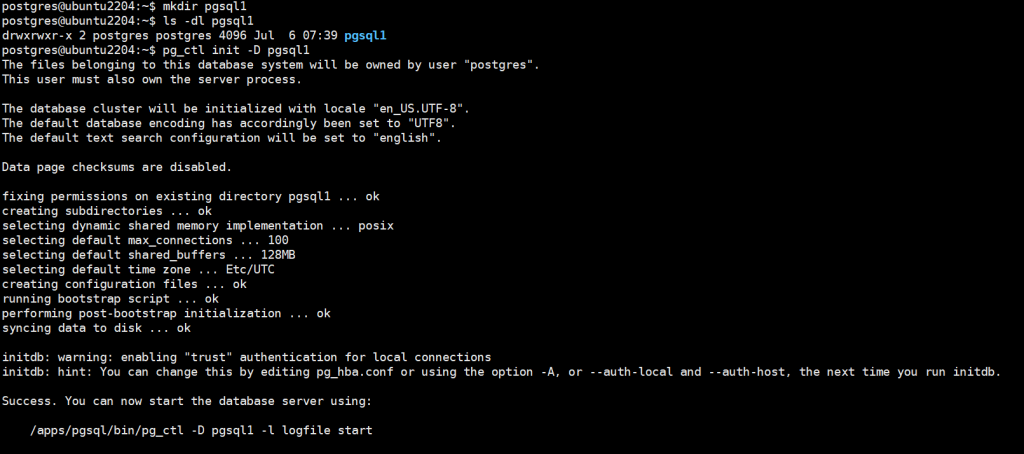

4、创建 cephFS 并验证

[ceph@deploy ceph-cluster]$ ceph fs new mycephfs cephfs-metadata cephfs-data

new fs with metadata pool 7 and data pool 8

[ceph@deploy ceph-cluster]$ ceph fs ls

name: mycephfs, metadata pool: cephfs-metadata, data pools: [cephfs-data ]

# 查看指定 cephFS 状态

[ceph@deploy ceph-cluster]$ ceph fs status mycephfs

![图片[3]-Ceph-FS 文件存储-李佳程的个人主页](http://www.lijiach.com/wp-content/uploads/2023/01/image-151.png)

5、验证 cepfFS 服务状态

[ceph@deploy ceph-cluster]$ ceph mds stat

mycephfs-1/1/1 up {0=mgr01=up:active}6、挂载 cephFS

在客户端挂在 mon 节点的 6789 端口

[root@client ceph]# mount -t ceph 192.168.1.114:6789:/ /mnt -o name=admin,secret=AQDhgLdjRBCPMBAAkyoxeR9+x32tbapU/oPYyA==

[root@client ceph]# df -TH

Filesystem Type Size Used Avail Use% Mounted on

devtmpfs devtmpfs 2.0G 0 2.0G 0% /dev

tmpfs tmpfs 2.0G 0 2.0G 0% /dev/shm

tmpfs tmpfs 2.0G 13M 2.0G 1% /run

tmpfs tmpfs 2.0G 0 2.0G 0% /sys/fs/cgroup

/dev/mapper/centos-root xfs 19G 2.4G 16G 13% /

/dev/sda1 xfs 1.1G 158M 906M 15% /boot

tmpfs tmpfs 396M 0 396M 0% /run/user/0

/dev/rbd0 xfs 1.1G 334M 730M 32% /data

192.168.1.114:6789:/ ceph 505G 0 505G 0% /mnt

[root@client ceph]# cp /var/log/messages /mnt/

[root@client ceph]# ll /mnt/

total 1005

-rw------- 1 root root 1028580 Jan 6 15:47 messages7、命令总结

列出存储池

[ceph@deploy ceph-cluster]$ ceph osd lspools

1 mypool

2 myrdb1

3 .rgw.root

4 default.rgw.control

5 default.rgw.meta

6 default.rgw.log

7 cephfs-metadata

8 cephfs-data

查看pg状态

[ceph@deploy ceph-cluster]$ ceph pg stat

224 pgs: 224 active+clean; 301 MiB data, 16 GiB used, 1.4 TiB / 1.5 TiB avail查看rbd状态

[ceph@deploy ceph-cluster]$ ceph osd pool stats myrdb1

pool myrdb1 id 2

nothing is going on

查看集群存储状态

[ceph@deploy ceph-cluster]$ ceph df

GLOBAL:

SIZE AVAIL RAW USED %RAW USED

1.5 TiB 1.4 TiB 16 GiB 1.07

POOLS:

NAME ID USED %USED MAX AVAIL OBJECTS

mypool 1 0 B 0 469 GiB 0

myrdb1 2 300 MiB 0.06 469 GiB 91

.rgw.root 3 1.1 KiB 0 469 GiB 4

default.rgw.control 4 0 B 0 469 GiB 8

default.rgw.meta 5 0 B 0 469 GiB 0

default.rgw.log 6 0 B 0 469 GiB 175

cephfs-metadata 7 7.4 KiB 0 469 GiB 22

cephfs-data 8 1004 KiB 0 469 GiB 1

结果分为两部分,GLOBAL 和 POOLS

GOOBAL:显示是存储量概括

POOLS:是存储池列表和对应的存储池的理论使用量。

SIZE:集群的整体存储容量

AVAIL:集群中可以使用的可用空间容量

RAW USED:已经的原始存储量

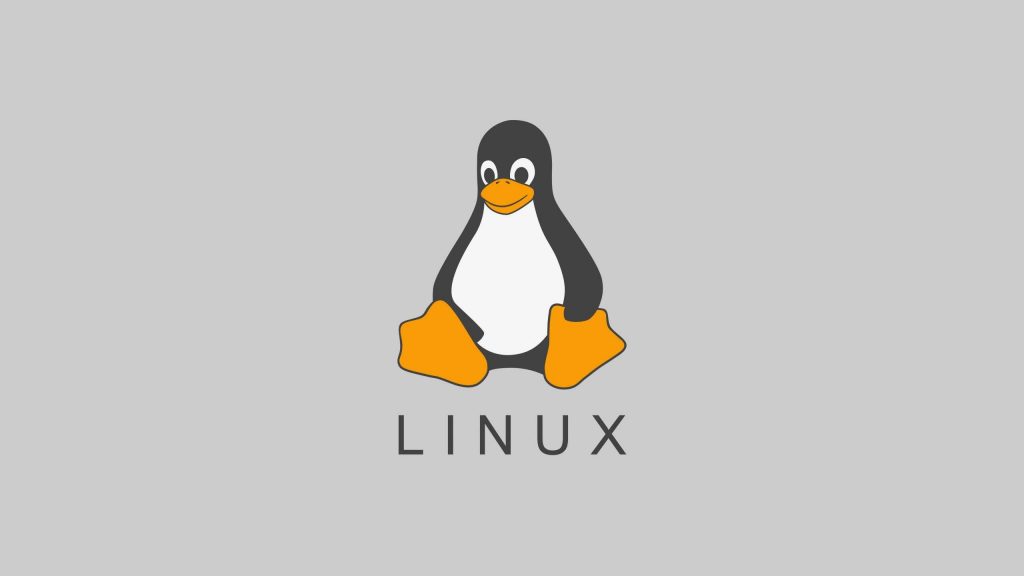

%RAW USED:已用的原始存储量百分比查看集群存储状态详情

[ceph@deploy ceph-cluster]$ ceph df detail

![图片[4]-Ceph-FS 文件存储-李佳程的个人主页](http://www.lijiach.com/wp-content/uploads/2023/01/image-152.png)

查看 osd 状态

[ceph@deploy ceph-cluster]$ ceph osd stat

15 osds: 15 up, 15 in; epoch: e88显示 OSD 的底层详细信息

[ceph@deploy ceph-cluster]$ ceph osd dump

epoch 88

fsid 845224fe-1461-48a4-884b-99b7b6327ae9

created 2023-01-06 10:01:05.814570

modified 2023-01-06 15:42:24.691554

flags sortbitwise,recovery_deletes,purged_snapdirs

显示 OSD 和节点的对应关系

[ceph@deploy ceph-cluster]$ ceph osd tree

ID CLASS WEIGHT TYPE NAME STATUS REWEIGHT PRI-AFF

-1 1.46530 root default

-3 0.48843 host node01

0 hdd 0.09769 osd.0 up 1.00000 1.00000

1 hdd 0.09769 osd.1 up 1.00000 1.00000

2 hdd 0.09769 osd.2 up 1.00000 1.00000

3 hdd 0.09769 osd.3 up 1.00000 1.00000

4 hdd 0.09769 osd.4 up 1.00000 1.00000

-5 0.48843 host node02

5 hdd 0.09769 osd.5 up 1.00000 1.00000

6 hdd 0.09769 osd.6 up 1.00000 1.00000

7 hdd 0.09769 osd.7 up 1.00000 1.00000

8 hdd 0.09769 osd.8 up 1.00000 1.00000

9 hdd 0.09769 osd.9 up 1.00000 1.00000

-7 0.48843 host node03

10 hdd 0.09769 osd.10 up 1.00000 1.00000

11 hdd 0.09769 osd.11 up 1.00000 1.00000

12 hdd 0.09769 osd.12 up 1.00000 1.00000

13 hdd 0.09769 osd.13 up 1.00000 1.00000

14 hdd 0.09769 osd.14 up 1.00000 1.00000 查看 mon 节点状态

[ceph@deploy ceph-cluster]$ ceph mon stat

e3: 3 mons at {mon01=192.168.1.114:6789/0,mon02=192.168.1.115:6789/0,mon03=192.168.1.116:6789/0}, election epoch 12, leader 0 mon01, quorum 0,1,2 mon01,mon02,mon03查看 mon 节点的 dump 信息

[ceph@deploy ceph-cluster]$ ceph mon dump

dumped monmap epoch 3

epoch 3

fsid 845224fe-1461-48a4-884b-99b7b6327ae9

last_changed 2023-01-06 10:48:24.304337

created 2023-01-06 10:01:05.622224

0: 192.168.1.114:6789/0 mon.mon01

1: 192.168.1.115:6789/0 mon.mon02

2: 192.168.1.116:6789/0 mon.mon03© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END